📅 モデル評価カード (Review Card)

まずは結論から。GLM-4.7を一言で表すと**「9割のOpus 4.5を、1割の価格で提供する実用主義の王者」**です。

| 評価項目 | スコア | 評価コメント |

|---|---|---|

| コスパ (Cost) | S+ | 圧倒的。標準版でもOpus 4.5の約1/10。Flash版に至っては測定誤差レベルの安さ。 |

| コーディング (Code) | A+ | SWE-bench Verified 73.8%。Opus 4.5には及ばないが、Sonnet 3.5に匹敵し、日常業務には十分以上。 |

| 日本語力 (JP) | A | 自然で流暢。DeepSeek-V3と同等以上の品質。複雑な論理推論でわずかにトップ層に劣る可能性あり。 |

| ツール利用 (Agent) | S | τ²-BenchでSOTA (84.7)。「行動する前に考える」機能が実装され、自律エージェント適性が非常に高い。 |

| 総合評価 | Must Try | 予算重視のプロジェクトや、大量のトークンを消費するエージェント開発には第一選択肢となる。 |

1. はじめに:「性能か、価格か」の時代は終わった

2025年末、Claude Opus 4.5の登場により、私たちは「真の知性」を手にしました。しかし、その代償は100万トークンあたり出力$25.00という高額な請求書でした。

「最高の性能を使いたいが、財布が持たない…」 そんなエンジニアの悩みを吹き飛ばすかのように登場したのが、Zhipu AI (Z.AI) のフラッグシップモデル、GLM-4.7です1。

このモデルの売りは単純明快。「Opus 4.5級の性能を、激安価格で」。 果たしてその看板に偽りはないのか?ベンチマークと実利用の両面から検証します。

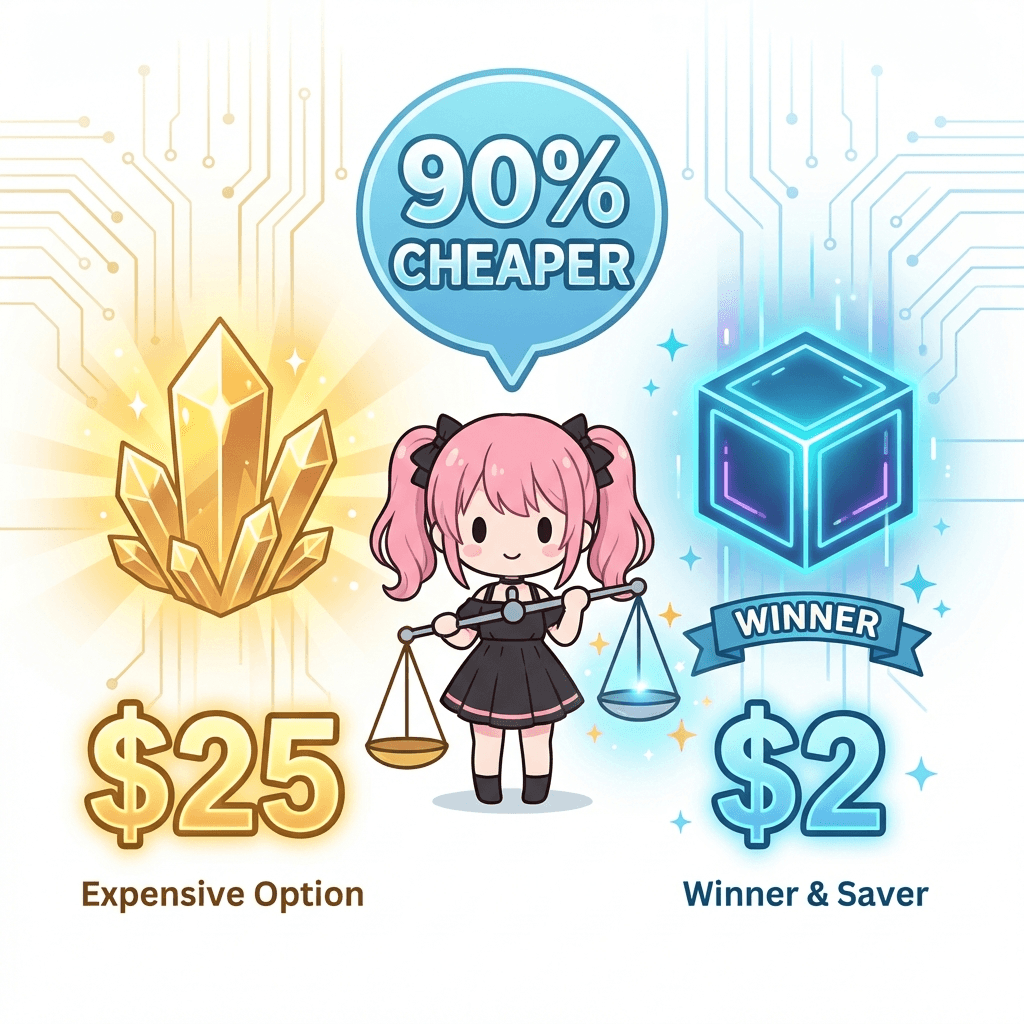

2. スペック・価格:驚異の「90% OFF」

まずは最も衝撃的な価格から見ていきましょう2。

価格比較(100万トークンあたり)

| モデル | 入力 (Input) | 出力 (Output) | Opus 4.5比 (出力) |

|---|---|---|---|

| Claude Opus 4.5 | $5.00 | $25.00 | 基準 |

| Claude 3.5 Sonnet | $3.00 | $15.00 | 40% OFF |

| GLM-4.7 (Standard) | $0.60 | $2.20 | 91% OFF |

| DeepSeek-V3 | ~$0.14 | ~$0.28 | 99% OFF |

GLM-4.7 (Standard)でも、Opus 4.5の約1/10の価格です。さらに驚くべきは、軽量版のGLM-4.7 Flash($0.07 / $0.40)の存在3。これはDeepSeek-V3と競合する価格帯であり、もはや「トークン課金を気にせず」思考の垂れ流しができるレベルです。

コンテキストウィンドウも200kトークン1を確保しており、長文ドキュメントの読み込みや、大規模なコードベースの解析にも十分対応できます。

3. 性能検証:本当にOpus 4.5に迫れるのか?

安くても使えなければ意味がありません。特にエンジニアが重視するコーディング性能はどうでしょうか。

コーディング能力 (SWE-bench Verified)

実務的なGitHubイシュー解決能力を測る SWE-bench Verified のスコアを見てみましょう45。

- Claude Opus 4.5: 80.9% (絶対王者)

- GLM-4.7: 73.8% (非常に優秀)

- Claude 3.5 Sonnet: ~49-82% (測定時期・手法によりブレあり)

Opus 4.5の「80.9%」という壁は厚いものの、GLM-4.7の「73.8%」は極めて高い数値です。これは、**「超難問以外はGLM-4.7で解ける」**ことを示唆しています。

エージェント適性:「考える」力

GLM-4.7の真骨頂は、単なるコード生成ではなくエージェントとしての振る舞いにあります。 新機能 “Interleaved Thinking” により、モデルはツールを利用する前に「思考プロセス」を挟むようになりました6。

これにより、τ²-Bench(ツール利用ベンチマーク)においてスコア84.7を記録し、Claude Sonnet 4.5を上回る結果を出しています7。 「自律的に考え、行動する」エージェントを作りたい場合、GLM-4.7はコストパフォーマンス最強の選択肢となり得ます。

4. 日本語能力:違和感ゼロの実力派

海外発のLLMで気になるのが「日本語力」。 結論から言うと、GLM-4.7の日本語は極めて自然です8。

- 文体: 翻訳調の不自然さがなく、ビジネスメールやブログ記事もそのまま使えるレベル。

- 文脈理解: 長文の日本語ドキュメントも正確に要約・抽出可能。

- 注意点: 非常に複雑な論理パズルや、日本独自の文脈依存度が高い推論に関しては、Opus 4.5やGPT-4oの方が一枚上手(うわて)な場面も見られます。

しかし、「DeepSeek-V3と同等以上」という評価が多く、日常使いで困ることはほぼないでしょう。

5. 結論:いつ乗り換えるべきか?

GLM-4.7は「Opus 4.5キラー」というよりは、**「Opus 4.5の請求書キラー」**です。

推奨する使い分け戦略:

- アーキテクチャ設計・最終確認 👉 Opus 4.5

- 絶対に失敗できない、最高精度の推論が必要な場面。ここにはお金を惜しまない。

- 日常のコーディング・リファクタリング 👉 GLM-4.7

- 9割のタスクはこれで十分。コストは1/10に圧縮。

- 自律エージェントのループ実行 👉 GLM-4.7 (or Flash)

- 試行錯誤を繰り返すエージェントには、安くて「思考」できるGLMが最適。

Soraのまとめ: 「『性能は妥協したくないけど、コストは下げたい』という欲張りなエンジニアさんにとって、GLM-4.7は救世主になりそうです!まずはFlash版でお試ししてみるのがオススメですよ!」

参考文献

Footnotes

Z.AI Release Blog: GLM-4.7 - GLM-4.7の公式リリース情報とスペック。 ↩ ↩2

Z.AI Pricing Page - 公式価格表。 ↩

LLM-Stats 2026: Pricing Comparison - モデル間の価格比較データ。 ↩

Anthropic News: Claude Opus 4.5 - Opus 4.5のSWE-benchスコア参照。 ↩

Vertu AI Benchmarks 2026 - 独立系ベンチマーク比較。 ↩

ModelScope: GLM-4.7 Features - Interleaved Thinkingの解説。 ↩

Z.AI Report: Tool Use - τ²-Benchのスコア詳細。 ↩

Note.com: GLM-4.7 日本語レビュー - 日本語性能の実機検証レビュー。 ↩